Workshop : ทำโปรเจกต์ Data Science จากข้อมูลผู้รอดชีวิตในเรือไททานิกบน Kaggle

February 6, 2019

เชิญชวนเพื่อนๆ ที่สนใจ Kaggle มารวมกลุ่นกันครับ!

March 8, 2019ส่อง Applications และงานวิจัยชั้นนำ (Update ทุกเดือน)

เริ่มต้นเขียน Game AI แบบ Turn-based Strategy ง่ายๆ (ตุลาคม 2021) การเขียน AI เพื่อวางแผนบนเกมส์ เช่น StarCraft และ Civilization หรือ AI ที่จำลองการใช้ชีวิตบนโลกเสมือนแบบ The Sims จะยิ่งสำคัญและน่าตื่นเต้นขึ้นเรื่อยๆ เมื่อเรากำลังเข้าสู่ยุค Metaverse ด้วยเทคโนโลยี VR และ AR

นั่นจึงทำให้ Game หรือ Bot AI ที่ใช้ชีวิตใน Virtual Environment เป็นหัวข้อที่น่าสนใจไม่แพ้หัวข้อ AI อื่นๆ ที่ร้อนแรงเช่น Deep Learning หรือ Data Science ทีเดียวครับ

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

พัฒนาเว็บ เกมส์ แอพมือถือ หรือทำงาน DataScience ต้องเรียนอะไรบ้าง? (กันยายน 2021) เนื่องจากการเรียนการเขียนโปรแกรมนั้นมีทั้งภาษา และ framework ที่หลากหลาย วันนี้เราจะมาแจกแจงแนวทางการเรียนรู้การเขียนโปรแกรมในแต่ละด้าน ที่ชอบส่วนตัวแบบย่อๆ ให้ฟังครับผม

รวมทั้งชี้เป้าที่เรียนออนไลน์นออนไลน์ภาษาไทยแบบละเอียดสุดๆ ผ่าน youtube ทาง Kongruksiam channel ครับ

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

โอกาสเรียนปริญญาจากมหาวิทยาลัยระดับท้อปของโลก ภัยซ่อนเร้นของมหาวิทยาลัยไทย (สิงหาคม 2021) รู้หรือไม่ว่า ตอนนี้ เราสามารถเรียนปริญญาโทจากมหาวิทยาลัยชั้นนำของโลกแบบออนไลน์ได้โดยสมบูรณ์

ได้ปริญญา ความรู้และทำงานกับศาสตราจารย์ระดับโลก มีเกียรติ ศักดิ์ศรีในฐานะศิษย์เก่าแบบเดียวกับไปเรียนที่ต่างประเทศ แถมยังประหยัดค่าใช้จ่ายได้มากกว่า 65-85% จากหลายล้านเหลือหลักแสน (ขึ้นกับมหาวิทยาลัยและค่าครองชีพในเมืองนั้นๆ)

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

AI ให้เหตุผลแบบ Commonsense ได้หรือไม่? (กรกฎาคม 2021) เชื่อกันว่า Commonsense (สามัญสำนึก) คือหนึ่งในคุณสมบัติที่จำเป็นของมนุษย์ซึ่งได้ชื่อว่าเป็นสิ่งมีชีวิตที่ "ทรงปัญญา" นอกจากนี้นักวิจัยแนวหน้าหลายกลุ่มยังเชื่อว่า commonsense คือส่วนประกอบสำคัญที่ทำให้โมเดลปัญญาประดิษฐ์ในปัจจุบันยังไปไม่ถึง "ความฉลาด" หรือ "ปัญญา" ในระดับเดียวกับมนุษย์

ในปัจจุบันเรามีโมเดลระดับ GPT-3 ซึ่งหลายๆ คนขึ้นชื่อว่าฉลาดที่สุดใกล้เคียงกับมนุษย์ ทว่านักวิจัยฝั่งปัญญาประดิษฐ์หลายกลุ่มก็ทำงานวิจัยเพื่อพิสูจน์ว่าจริงๆ แล้ว GPT-3 นั้นมี commonsense น้อย ในบทความล่าสุดนี้เราจะเจาะลึกว่าโมเดลอย่าง GPT-3 นั้นสามารถให้เหตุผลแบบ Commonsense ได้ดีแค่ไหนกันแน่

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

GPT-J-6B ประสิทธิภาพสูสีกับ GPT-3 Curie (ตัวรองท้อป) พร้อมให้ดาวโหลดมาใช้งานแล้ว! (มิถุนายน 2021 -2) โมเดล GPT-J-6B นี้ implement บน Jax ซึ่งเป็น Deep Learning library มาแรงโดยสามารถทำ Autograd และ XLA ได้โดยใช้คำสั่งแบบเดียวกับ Numpy ทำให้ง่ายต่อการใช้งานกว่า Tensorflow หรือ Pytorch

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

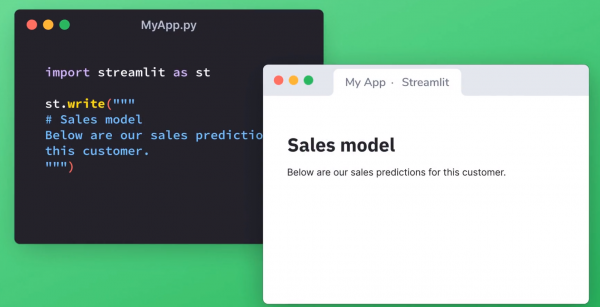

Deploy โมเดลเป็น Web App ง่ายแบบปลอกกล้วย ด้วย Streamlit (พฤษภาคม 2021) วันนี้จะแชร์หนึ่งในวิธี Deploy โมเดลของเราบน web app ที่ง่ายและเร็วที่สุดในจักรวาลด้วย Python library ที่ชื่อว่า streamlit ซึ่งเป็นการสร้าง web app ที่ง่ายที่สุด สร้างได้ภายในไม่กี่นาที แถมยัง host ฟรีอีกด้วย

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

ใช้งาน GPT3 โมเดลภาษาที่ฉลาดที่สุดเท่าที่เคยมีมา (เมษายน 2021)สวัสดีครับเพื่อนๆ หลังจากที่เราได้เล่า applications เจ๋งๆ ของ GPT3 ในบทความเดือนก่อน http://bit.ly/thaikeras-openai-gpt ทาง ThaiKeras ก็ได้รับ surprise จาก OpenAI ที่อนุญาตให้เราทดลองใช้งาน GPT3 ได้อย่างเป็นทางการครับ!!

เราสามารถให้ GPT3 เขียนเรื่องราวสร้างสรรค์เรื่องราวอะไรก็ได้เหมือนกับมนุษย์ โดยใช้ภาษาอังกฤษเป็นสื่อกลาง หรือจะใช้ภาษาไทยผ่าน Translator API ก็ย่อมได้ (ตัวอย่าง https://bit.ly/thaikeras-kaggle-gpt2thai ) ดังนั้นน่าสนใจมากๆ ภาคธุรกิจหรือ Startup ในบ้านเราจะสามารถนำพลังของ GPT3 มาประยุกต์ได้อย่างไรบ้าง

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

Applications เจ๋งๆ ของ AI (มีนาคม 2021) ในบทความนี้เราจะมาดูหลายๆ Applications เจ๋งๆ ของ AI กันครับ โดยสำหรับ Applications ด้านภาษาและเกมส์กดดูได้ที่นี่ครับ ส่วน Applications ที่ช่วยเก็บขยะรักษาสิ่งแวดล้อมดูได้ที่นี่ครับ

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

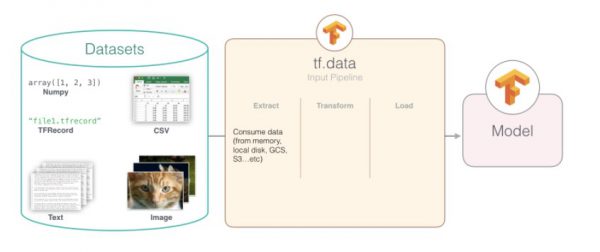

การสร้าง Data Pipeline ใน Tensorflow-Keras 2.x (กุมพาพันธ์ 2021 - 2) ด้วยพลังของ TF-Keras นั้น การสร้างและฝึกสอนโมเดล Deep Learning สามารถทำได้ภายในไม่กี่บรรทัด ดังนั้นในทางปฏิบัติประสิทธิภาพของโมเดลที่เราสร้างขึ้นจะใช้งานจริงได้ดีแค่ไหน จะขึ้นอยู่กับ "การเตรียม" ข้อมูลฝึกสอนของเราเป็นหลักครับ การเตรียมข้อมูลฝึกสอนนี้มักเรียกว่า "การสร้าง Data Pipeline"

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ

เรียนรู้การสร้างโมเดลรู้จำเสียง ผ่าน Kaggle : Rainforest Audio Detection (กุมภาพันธ์ 2021) สำหรับคนที่สนใจวิธีการสร้างโมเดลที่รู้จำเสียงต่างๆ ได้ (input เป็นเสียง) หรือผู้ที่สนใจประยุกต์ AI/Data Science กับงานด้าน "วิทยาศาสตร์สิ่งแวดล้อม" (Environmental Science) วันนี้มีโอกาสดีดี ให้ลองเรียนรู้ผ่านการแข่งขันบน Kaggle ที่ชื่อว่า Rainforest Audio Detection หรือ "รู้จำเสียงสัตว์ต่างๆ ในป่าดงดิบ"

เพื่อนๆ สามารถกดที่รูปเพื่อเข้าสู่บทความได้เลยครับ