AI, Machine Learning และ Deep Learning เกี่ยวข้องกันอย่างไร

November 10, 2020กำเนิด Deep Learning : จากงานวิจัยในห้องแล็บ กลายเป็นเทคโนโลยีพลิกโลก (อัพเดต 2020)

AI, Machine Learning และ Data Science เป็นสาขาที่มาแรงมากทั้งในโลกวิชาการ และโลกธุรกิจ รู้หรือไม่ว่าทั้งสามสาขานี้กลายเป็นสุดยอดเทคโนโลยีในฝันของคนทั้งโลกในปัจจุบัน ก็เนื่องด้วยพลังของเทคโนโลยีที่ชื่อ "Deep Learning" ที่เป็นรากฐานสำคัญของเทคโนโลยีเหล่านี้

อันที่จริงทั้ง AI, Machine Learning และ Data Science นั้นกำเนิดมาไม่ต่ำกว่า 50 ปีแล้ว แต่ไม่ได้ดังเหมือนทุกวันนี้ เพราะว่าก่อนหน้าที่จะมีการคิดค้นเทคโนโลยี Deep Learning ได้นั้น พลังของ AI และ Machine Learning นั้นต่ำกว่าทุกวันนี้มาก ดังนั้น Deep Learning จึงเป็นเหมือนเวทมนต์ศักดิ์สิทธิ์ที่ชุบชีวิต AI, Machine Learning และ Data Science ให้คนทั้งโลกรู้จักอีกครั้ง

ต้นกำเนิดของ Deep Learning นั้นเริ่มมาจากคำถาม “คอมพิวเตอร์จะสามารถฉลาดเหมือนมนุษย์ได้หรือไม่??” ซึ่งก่อนที่เราจะตอบคำถามนี้เราคงต้องมาตกลงกันก่อนว่าเราจะนิยามของ “ความฉลาด” นั้นเป็นอย่างไร

ราวๆ ช่วงต้นปี 2000 ในวงการ AI เป็นที่เห็นตรงกันว่า การที่จะเรียกว่าคอมพิวเตอร์นั้น “ฉลาด” อย่างน้อยที่สุดควรจะทำเรื่องปกติสามัญที่มนุษย์นั้นทำได้แบบสบายๆ (แต่สัตว์ประเภทอื่นอาจจะทำไม่ได้ดี หรือทำไม่ได้เลย) ตัวอย่างเช่น การเข้าใจตัวหนังสือ การเข้าใจเสียงพูดต่างๆ หรือการเข้าใจภาพต่างๆ เป็นต้น โดยก่อนหน้ายุค Deep Learning นั้นเรายังไม่มีวิธีที่แม้แต่จะให้คอมพิวเตอร์สามารถเข้าใจสิ่งเหล่านี้ในระดับใกล้เคียงเด็กประถม (ที่สามารถแต่งเรียงความ ออกมาพูดหน้าชั้น หรือวาดรูปตามหัวข้อที่กำหนดได้) ดังนั้นแม้นว่าในยุคนั้นเราจะพบวิธีที่ทำให้คอมพิวเตอร์ฉลาดเฉพาะด้าน เช่น สามารถเล่นหมากรุกเอาชนะมือวางอันดับหนึ่งของโลกได้แล้ว แต่เราก็ยังไม่สามารถคิดค้นวิธีให้คอมพิวเตอร์ฉลาดในเรื่องพื้นฐาน เช่น ฟัง พูด อ่าน เขียนได้ ดังนั้นในยุคก่อน Deep Learning เราจึงยังไม่สามารถกล่าวได้เต็มปากนักว่าคอมพิวเตอร์หรือ AI นั้น “ฉลาด” อย่างแท้จริง

1. ImageNet Recoginition Challenge!

ต่อมา ในช่วงราวๆ ปี 2009 - 2010 กลุ่มนักวิจัยจาก Princeton และ Stanford นำโดยนักวิจัยหญิง Fei Fei Li ได้มีความพยายามที่จะสร้างมาตรฐานเพื่อวัดความฉลาดของระบบ AI อย่างจริงจัง บนมุมมองของการ “เข้าใจสิ่งที่อยู่ในรูปภาพ” (Image Recognition)

ในปัญหา Image Recognition เราจะทดสอบความสามารถของ AI ในการทำความเข้าใจรูปภาพโดยการป้อนให้ระบบ AI ดูรูปทีละรูป แล้วให้ระบบตอบว่า “รูปดังกล่าวเป็นรูปของวัตถุใด”

ตัวอย่างภาพจากชุดข้อมูลทดสอบขนาดยักษ์ “ImageNet” — เพื่อนๆ สามารถตอบได้ทุกรูปหรือไม่ว่าแต่ละรูปคือรูปอะไร? สังเกตว่าบางรูปนั้นกำกวมเนื่องจากมีวัตถุมากกว่า 1 ชนิดอยู่ในภาพเดียวกัน (เช่นมีทั้งพิซซ่าและขวดเบียร์) หรืออยู่ในความมืดใต้แสงไฟ เป็นต้น

เพื่อให้ชุดข้อมูลรูปภาพ หรือ Image Dataset ที่จะนำมาทดสอบนี้มีคุณภาพสูงสุดและให้ท้าทายนักวิจัยจากทุกมุมโลก ทีมของ Fei Fei Li จึงได้ระดมพลังและระดมทุนโดยการเตรียมรูปภาพทดสอบไว้มากกว่า 1.4 ล้านรูป และครอบคลุมวัตถุทั้งหมด 1,000 ชนิด โดยทุกรูปภาพจะมีมนุษย์ได้เฉลยคำตอบที่แท้จริงกำกับไว้ว่าแต่ละรูปนั้นเป็นรูปของวัตถุอะไร Dataset ชุดนี้มีชื่อว่า ImageNet และทางทีมงานจึงได้จัดการแข่งขันประจำปีที่มีชื่ออย่างเป็นทางการว่า ImageNet Large Scale Visual Recognition Challenge (ILSVRC) ขึ้น โดยเชิญชวนให้นักวิจัยจากทุกมุมโลกเข้าร่วม และการแข่งขันนี้ได้เป็นจุดกำเนิดของการปฏิวัติวงการ AI

จริงๆ แล้วในช่วงเวลาก่อนหน้าที่จะมี ImageNet Dataset นี้ ได้มีนักวิจัยหลายกลุ่มได้พยายามสร้าง Dataset มาตรฐานเพื่อให้นักวิจัยจากทุกมุมโลกได้มาวัดความสามารถเช่นเดียวกัน แต่ Dataset ชุดอื่นๆ นั้นมีรูปหลักหมื่นรูปและมักมีชนิดของวัตถุไม่เกิน 100 ชนิด ดังนั้นจึงถือได้ว่ามีความง่ายกว่า ImageNet มาก อย่างไรก็ดีความแม่นยำของ AI ในการจำแนกรูปภาพใน Dataset อื่นๆ นั้นก็ยังไม่ได้อยู่ในระดับเกรด A กล่าวคือมีความแม่นยำอยู่ที่ราวๆ 70% กว่าๆ ดังนั้น ณ เวลานั้นการประลอง ILSVRC นี้จึงถือได้ว่าเป็นงานมหาหินที่มีแต่นักวิจัยสุดยอดของโลกเท่านั้นที่รับคำท้า และผลลัพธ์ของการงานนี้ก็ถูกจับจ้องไปทั่วโลก

สาเหตุที่ทำให้ชนิดข้อมูลของ ImageNet นั้นเป็นงานที่ท้าทายและมหาโหดไม่ได้เป็นเพราะข้อมูลมีปริมาณมหาศาลกว่า Dataset ชุดก่อนหน้าเท่านั้น แต่เป็นเพราะผู้ที่จะทำคะแนนได้สูงในข้อมูลของ ImageNet ต้องมีทั้งความรู้หลากหลายและความรู้ในระดับลึกเป็นอย่างมาก

โดยวัตถุในรูปมีตั้งแต่วัตถุขนาดเล็กจิ๋วเมื่อเทียบกับขนาดรูปเช่นเทียนแท่งเล็กๆ ไปจนถึงวัตถุขนาดใหญ่จนเกือบเต็มรูปเช่นใยแมงมุม หรือมีวัตถุรูปทรงแตกต่างกันมากมาย หลากหลายสีสันและลวดลาย นอกจากความหลากหลายแล้ว AI ยังต้องเข้าใจวัตถุในเชิงลึกมาก ยกตัวอย่างเช่น ในบรรดาวัตถุทั้ง 1,000 ชนิดนั้น มีพันธุ์สุนัขถึง 120 ชนิด (รวมทั้งแมว นกและต้นไม้อีกหลายสิบชนิด) นั่นก็คือไม่เพียงแค่ว่า AI จะต้องทราบว่าในภาพเป็นสุนัข หรือแมว แต่ยังต้องระบุให้ชัดเจนด้วยว่าเป็นแมวเปอร์เซียหรือแมวอียิปต์ และเป็นสุนัขพันธ์ Miniature Schnauzer, Standard Schnauzer หรือ Giant Schnauzer (ดูรูปตัวอย่าง) เพื่อนๆ คงพอเห็นภาพแล้วใช่ไหมครับว่าการประลองนี้ท้าทายแค่ไหน ต่อให้เป็นพวกเราเองที่พอจะดูออกว่าในภาพเป็นสุนัขหรือแมว แต่จะให้ระบุสายพันธุ์ที่ชัดเจน (ทั้งสุนัข แมว นก ต้นไม้พร้อมๆ กัน) นั้นต้องเป็นระดับผู้เชี่ยวชาญหลายคนมานั่งช่วยกันตอบเลยทีเดียว ดังนั้นโปรแกรม AI ที่สามารถจำแนกวัตถุต่างๆ เหล่านี้ได้จำเป็นต้องมีความเข้าใจเรื่องวัตถุในระดับลึกซึ้งมาก

ImageNet นั้นมีความหลากหลายมาก มีตั้งแต่วัตถุขนาดเล็กจิ๋วเมื่อเทียบกับขนาดรูปไปจนถึงวัตถุขนาดใหญ่จนเกือบเต็มรูป มีวัตถุรูปทรงแตกต่างกันมากมาย หลากหลายลวดลายและสีสัน

ในการประลอง ImageNet Challenge นั้นไม่เพียงแค่ว่า AI จะต้องทราบว่าในภาพเป็นสุนัข หรือแมว แต่ยังต้องระบุให้ชัดเจนด้วยว่าเป็นแมวเปอร์เซียหรือแมวอียิปต์ และเป็นสุนัขพันธ์ Miniature Schnauzer, Standard Schnauzer หรือ Giant Schnauzer

1 ในงานที่หินที่สุดคือการแยกประเภทของต้นไ้ม้ ซึ่งผู้ชนะเลิศนั้นทายได้ถูกต้องเพียงราวๆ 20% (ถึงแม้จะทายได้ 5 ครั้ง)

เนื่องจากทุกฝ่ายเข้าใจตรงกันถึงความยากของการประลองนี้ จึงได้อนุญาตให้ AI สามารถทายได้ 5 ครั้ง นั่นคือในแต่ละรูปถ้าระบบสามารถทายวัตถุได้ถูกต้องอย่างน้อย 1 ครั้งจาก 5 ครั้งก็จะได้คะแนนของภาพนั้นเต็มๆ ไปเลย

ผลจากการระดมสมองของนักวิจัยทั่วโลกถือได้ว่าน่าประทับใจ โดยกลุ่มผู้ชนะเลิศอันดับต้นๆ ในปี 2010 นั้นสามารถนำความรู้ Machine Learning และ Computer Vision ทั้งหมดที่นักวิจัยทั่วโลกร่วมกันคิดค้นมาหลายสิบปี มาประยุกต์ให้มีประสิทธิภาพสูงสุดและสามารถทำนายประเภทวัตถุได้ถึงราวๆ 70% ซึ่งนับว่าน่าประทับใจมากสำหรับข้อมูลที่มีความยากระดับมหาโหดอย่าง ImageNet (เทียบกับการเดาสุ่มจะมีความถูกต้องเพียง 0.5% เท่านั้น)

ตัวเลขความแม่นยำระดับ 70% นี้ถึงแม้นจะน่าประทับใจ แต่ทว่าด้วยความที่ว่าเราได้รวมความรู้และแทคติกแทบทุกชนิดที่มนุษย์ร่วมคิดค้นกันมาใช้แล้ว ทำให้ผลการแข่งขันใน 3 ปีแรกแทบไม่มีความคืบหน้า นั่นคือนักวิจัยทั่วโลกนั้นยังไม่สามารถพัฒนาให้ระบบมีขีดความสามารถทะลุกรอบ 70% ไปได้เลย นั่นคือทุกทีมต่างก็ไม่มีวิธีที่จะพัฒนาขีดความสามารถของระบบได้อย่างชัดเจน จะมีก็เพียงแต่ลูกเล่นต่างๆ ที่เพิ่มมาที่ทำให้ความถูกต้องเพิ่มขึ้นได้เล็กน้อย ... ที่กล่าวมาทั้งหมดเกือบจะเป็นเรื่องจริง ถ้าไม่นับว่ามีทีมหนึ่งทีมเดียวจาก University of Toronto ที่จู่ๆ ในปี 2012 ก็สามารถชนะผู้เข้าแข่งขันคนอื่นๆ ไปได้ขาดลอยด้วยการทำลายกรอบเดิมๆ โดยการแทบจะโยนความรู้ด้าน Computer Vision และ Machine Learning ที่ขึ้นชื่อว่าดีที่สุดทิ้ง และทำให้เปอร์เซนต์ความถูกต้องของการทำนายขึ้นเป็น 85% ได้เป็นครั้งแรก

ปรากฏการณ์นี้สร้างความตื่นตะลึงให้กับวงการ AI ไปทั่วโลก (รวมทั้งสร้างความตกใจให้นักวิจัยระดับโลกทั้งหลายในตอนนั้น เมื่อพบว่าความรู้และเทคนิกที่พวกเขาช่วยกันคิดค้นและวิจัยขึ้นมาหลายสิบปีนั้น “ไม่จำเป็น”) และนับว่าเป็นก้าวแรกที่ทั่วโลกเริ่มรู้จักชื่อของ Deep Learning

2. The Rise of Deep Learning

ความแม่นยำของ AI ใน ImageNet นั้นเมื่อเทียบกับมนุษย์แล้วเป็นอย่างไรบ้าง? โดยทั่วไปแล้วแม้แต่มนุษย์ระดับที่เชี่ยวชาญเรื่องภาพก็ยังประสบความยากลำบากในการจำแนกภาพว่าเป็นภาพของวัตถุชิ้นใดกันแน่ในบรรดา 1,000 ชนิดที่เป็นไปได้ มีบุคคลผู้หนึ่งซึ่งอยากทราบขีดความสามารถสูงสุดของมนุษย์ในการจำแนกภาพของข้อมูลชุดนี้เป็นอย่างมาก และได้ตัดสินใจที่จะฝึกฝนตัวเองเป็นเวลาหลายสัปดาห์เพื่อเรียนรู้ชนิดของภาพต่างๆ ใน ImageNet และเพื่อวัดความสามารถของมนุษย์เทียบกับ AI

บุคคลดังกล่าวคือนักศึกษาปริญญาเอกแห่ง Stanford คนหนึ่งในทีมงานของ Fei Fei Li นั่นเอง หนุ่มผู้นี้มีชื่อว่า Andrej Karphaty (ซึ่งนับเป็นนักวิจัยระดับหัวกะทิคนนึงของโลกในยุคปัจจุบัน ณ ปี 2018 เด็กหนุ่มคนนี้กลายเป็นหัวหน้าห้องแล็บ AI ของ Tesla) Andrej ได้ฝึกฝนการแยกแยะวัตถุ 1000 ชนิดในรูปอย่างจริงจังเพื่อแข่งกับระบบ AI ทั้งหลาย และพบว่าแม้แต่มนุษย์ที่ตั้งใจแยกแยะรูปภาพอย่างจริงจัง และมีการเตรียมตัวที่ดีพร้อม ก็จะมีความผิดพลาดราวๆ 5% ซึ่งตัวเลขนี้นับเป็น Human Benchmark ของ ImageNet และเชื่อกันว่าเป็น limit ความถูกต้องสูงสุดอย่างหยาบๆ ที่ไม่น่าจะมีคนหรือระบบใดๆ เอาชนะได้ (ส่วนตัวผู้เขียนบทความเคยลองนั่งจำแนกภาพเล่นๆ คิดว่าน่าจะได้เปอร์เซนต์ความผิดพลาดไม่ต่ำกว่า 10-20% แน่นอน)

หลังจากปี 2012 เป็นต้นมา การประลองยุทธบน ImageNet ก็เปลี่ยนจากหน้ามือเป็นหลังมือ ตั้งแต่ปี 2013 เป็นต้นมา ผู้เข้าแข่งขันทุกทีมล้วนพัฒนาระบบ AI บน Deep Learning! และงานวิจัยเรื่อง Deep Learning ก็ได้ตื่นตัวและพัฒนาไปอย่างติดจรวด ความแม่นยำบนข้อมูลชุด ImageNet เพิ่มเป็น 89% ในปี 2013 โดยทีมวิจัยจาก New York University และทะลุกรอบ 90% เป็น 93% ในปี 2014 โดยทีมวิจัยจาก Google และเพียง 3 ปีนับจาก Deep Learning ออกสู่โลกกว้าง ในปี 2015 นั้น นักวิจัยจาก Microsoft ก็พัฒนา Deep Learning ที่มีความแม่นยำถึง 96.5% ซึ่งเอาชนะมนุษย์ระดับผู้เชี่ยวชาญไปได้อย่างสวยงาม ในปี 2017 เรามีระบบ AI ที่มีความแม่นยำราว 98% และปัญหา ImageNet นี้ถือกันว่าถูกปราบแล้วโดยสมบูรณ์

โมเดลผู้ชนะใน ImageNet ที่ยังใช้กันได้ดีอยู่ในปัจจุบัน

- 2012 : AlexNet (ทีม Toronto และ Google)

- 2014 : InceptionNet (ทีม Google)

- 2015 : ResNet (ทีม Microsoft)

- 2016 : ResNeXt (ทีม Facebook)

- 2019 : EfficientNet (ทีม Google)

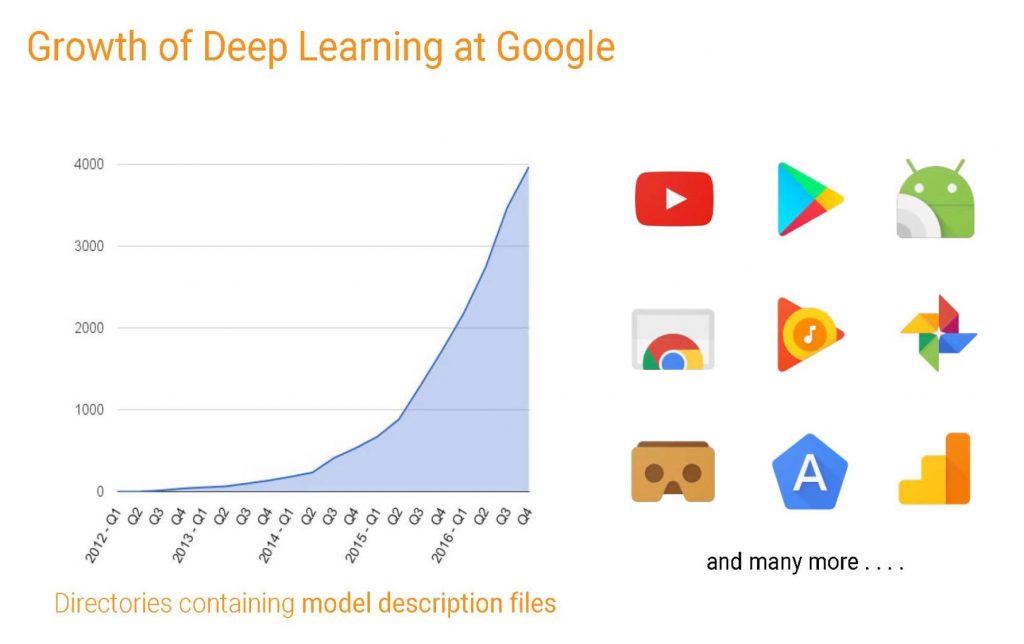

เมื่อปัญหาที่เรียกได้ว่า “มหาหิน” อย่าง ImageNet ถูก Solved ได้อย่างสวยงาม นับแต่ช่วงปี 2013 เป็นต้นมา นักวิจัยในด้านอื่นๆ ต่างก็ทดลองนำ Deep Learning ไปประยุกต์เข้ากับปัญหาของตน ไม่ว่าจะเป็น “การประมวลผลภาษาธรรมชาติ” หรือ Natural Language Processing (NLP) อาทิเช่น การแปลภาษา การย่อความ หรือการแต่งบทความ, “การรู้จำเสียง” หรือ Speech Recognition การจำแนกภาพเคลื่อนไหวหรือวีดิโอ และปัญหาอื่นๆ อีกนับไม่ถ้วนที่นับว่ายากมากๆ และไม่มีความก้าวหน้าแบบก้าวกระโดดกันมานาน ... ผลลัพธ์ที่ได้น่ะหรือ? ก็คือการปฏิวัติวงการ Technology ทั้งหมด! ทั้งนี้เนื่องจาก Deep Learning กลายเป็นเทคนิกที่ดีที่สุดในการแก้ปัญหาเหล่านั้น (และเทคนิกก่อนหน้าแทบจะไม่จำเป็น) และเป็นเหตุผลที่ทำให้ Deep Learning เป็นที่รู้จักและตื่นตัวไปทั่วโลกจนถึงทุกวันนี้ เพื่อจะให้เห็นภาพง่ายๆ มหาอำนาจของวงการ AI อย่าง Google เริ่มใช้ Deep learning เป็นครั้งแรกเมื่อปี 2012 (เชิญทีมงานจาก Toronto ผู้ชนะงาน ImageNet 2012 เพื่อเข้าไปแชร์ความรู้) ในปัจจุบันงานด้าน AI ของ Google ทั้งหมดหลายพันรายการ ทั้ง Google Search, Gmail, Google Map, Youtube, Google Ads, Chrome, Google Play, Picasa และแอพชื่อดังอื่นๆ อีกมากมาย ล้วนใช้ Deep Learning เป็นศูนย์กลาง (เช่นเดียวกับศูนย์ AI ของ Facebook, Microsoft, Amazon และที่อื่นๆ)

Deep Learning ที่ Google (Jeff Dean’s presentation)

3. Deep Learning Fundamental

อะไรคือความแตกต่างระหว่าง Deep Learning กับ Machine Learning ในยุคก่อนหน้า ?? คำถามนี้แท้จริงแล้วถ้าจะตอบเชิงลึกจำเป็นต้องใช้ความเข้าใจทางคณิตศาสตร์มาเสริม แต่ในหัวข้อนี้เราจะพยายามอธิบายให้เห็นภาพให้มากที่สุดโดยไม่ต้องใช้คณิตศาสตร์

เพื่อให้ยกตัวอย่างง่ายที่สุด เมื่อคนเราเห็นภาพของ “รถยนต์” “สุนัข” และ “มนุษย์” เราทราบได้อย่างไรว่าแต่ละรูปคือรูปของอะไร ? แน่นอนรถยนต์นั้นไม่มี “ตา” “หู” “จมูก” และ “ปาก” ดังนั้นการจำแนกรถยนต์ออกจากสิ่งอื่นๆ อาจจะทำได้ง่ายกว่าเพื่อน ส่วนการจะจำแนกรูประหว่างสุนัขและคนนั้น บางคนอาจจะกล่าวว่า สุนัขนั้นจมูกยาวกว่าคน บางทีก็หูยาวกว่า รวมทั้งมีขนเยอะกว่า เป็นต้น

ที่พูดมาข้างต้นนั้นเป็นเรื่องที่ง่ายยิ่งกว่าปอกกล้วยสำหรับมนุษย์ แต่สำหรับคอมพิวเตอร์หรือ AI ล่ะ ?? อย่าลืมว่าคอมพิวเตอร์นั้นเริ่มแรกสุดเข้าใจรูปภาพในลักษณะของ pixel ซึ่งก็คือจุดสีเล็กๆ ที่ร้อยเรียงต่อกันเป็นล้านๆ จุดเท่านั้น คอมพิวเตอร์ไม่มีทางรู้ว่าอะไรคือ “ตา” “หู” “จมูก” “ปาก” หรือ “ขน” เป็นต้น และ concepts ของชิ้นส่วนเหล่านี้ไม่สามารถเขียนโปรแกรมให้คอมพิวเตอร์จำตรงๆ ได้ เนื่องจากการที่ ใบหน้าของคนเราขยับไปเล็กน้อยในแต่ละรูปนั้น ต่างก็ทำให้ pixel ของ ตา จมูก หู หรือปาก นั้นแตกต่างจากรูปเดิมไปมาก

ในเทคนิกดั้งเดิมของ Machine Learning นั้น การให้ความรู้กับคอมพิวเตอร์เกี่ยวกับ “คุณลักษณะ” (Features) ที่สำคัญส่วนใหญ่ในรูปภาพนั้น (เช่น ตา หู จมูก ปาก) ส่วนใหญ่เกิดจาก “ความรู้พื้นฐานของมนุษย์” ที่เราจินตนาการออกมาได้ รวมทั้ง “ความรู้คณิตศาสตร์ระดับสูง” ที่เราใส่ลงไปในโมเดลเพื่อให้โมเดลนั้นสามารถคำนวนสิ่งต่างๆ ที่ซับซ้อนได้อย่างมีประสิทธิภาพ

อย่างไรก็ดี แม้แต่ “ความรู้พื้นฐานของมนุษย์” และ “ความรู้คณิตศาสตร์ระดับสูง” ของมนุษย์นั้นก็ยังไม่เพียงพอต่อการ “อธิบาย” สิ่งต่างๆ ที่ซับซ้อนมากๆ เกินความเข้าใจของเรา (อาทิเช่น pixels มารวมกันแบบไหนถึงควรเรียกว่าเป็นจมูกสุนัข และ pixels มาต่อกันแบบไหนถึงควรเรียกว่าเป็นจมูกมนุษย์ — เราอาจพอบอกได้คร่าวๆ เช่น โดยเฉลี่ยจมูกมนุษย์ยาว 5 ซม. และจมูกสุนัขยาว 10 ซม. เป็นต้น แล้วถ้ารูปที่ถ่ายระยะใกล้หรือไกลล่ะ จะคำนวนความยาวอย่างไร?) ดังนั้นความสามารถของ Machine Learning ในยุคก่อนหน้า Deep Learning จึงชะงักอยู่เป็นเวลานานดังที่ผมไ้ด้เล่าในตอนต้น ในเรื่องราวของ ImageNet เนื่องจากเรายังไม่มีทฤษฎีที่รองรับความซับซ้อนปัญหาขนาดใหญ่เช่นระดับ ImageNet ที่จำเป็นต้องจำแนกวัตถุเป็น 1000 ประเภทได้ ไม่ใช่แค่ 3 ประเภทดังตัวอย่างง่ายๆ ของเรานี้

พลังของ Deep Learning นั้นเริ่มจากการเปลี่ยนมุมมองในการแก้ปัญหานี้ใหม่ทั้งหมด โดยแทบจะโยนคณิตศาสตร์ระดับสูงเหล่านั้นทิ้ง (เหลือแต่สมการคณิตศาสตร์ของ Deep Learning ซึ่งซับซ้อนน้อยกว่ามาก) แต่นำสมการที่เรียบง่ายเหล่านั้นมาต่อกันเป็นทอดๆ เป็นร้อยๆ ชั้น (ในลักษณะที่มนุษย์ไม่สามารถทำความเข้าใจตรงๆ ได้ว่าเมื่อนำสมการง่ายๆ มาคำนวนเชื่อมกันเป็นร้อยๆ ทอดแล้วจะเกิดอะไรขึ้น) เทคนิกการรวมสมการที่ง่ายๆ เหล่านี้เข้าด้วยกันโดยมีตัวแปรทั้งหมดนับล้านตัวแปรนี้ประสบความสำเร็จอย่างเหลือเชื่อ และสามารถอธิบายสิ่งต่างๆ ที่มีความซับซ้อนสูงมากได้ ดังรูป

Intuition ของ Deep Learning — ในโมเดลของ Deep Learning นี้แท้จริงแล้วประกอบไปด้วยสมการคณิตศาสตร์จำนวนมหาศาล และโดยทั่วไปมีตัวแปรนับล้านตัวแปร (บางระบบมีตัวแปรได้ถึงหลายร้อยล้านหรือกระทั่งหนึ่งพันล้านตัวแปร) เพื้อให้เห็นภาพขอเทียบกับสมการเส้นตรงที่เราเรียนสมัยมัธยม เช่น y = ax + b นั้นเรียกได้ว่ามีตัวแปรเพียงสองตัวแปรเท่านั้น!

4. Deep Learning ทำอะไรได้บ้าง

Deep Learning ทำอะไรได้บ้าง? ก่อนอื่นคงต้องบอกว่าเนื่องจากปัจจุบัน Deep Learning เป็นกระแสของโลกและมีนักพัฒนาและนักวิจัยรุ่นใหม่ที่มีความคิดสร้างสรรค์มากมายอยู่ในวงการ เราคงไม่สามารถบรรยายได้ครบถ้วนว่า Deep Learning สามารถทำอะไรได้บ้าง (สำหรับแหล่งรวม Applications ชั้นแนวหน้าดูได้ที่นี่ครับ)

ในที่นี่จะขอเล่าในมุมมองที่ว่า Deep Learning นั้นจริงๆ แล้วประโยชน์ของมันมีแนวคิดพัฒนาต่อยอดมาจาก “สถิติศาสตร์” ที่เราร่ำเรียนกันมาแต่เดิม ทั้งนี้เป็นเพราะว่าในภาพใหญ่ Deep Learning ก็คือการ “เรียนรู้” จาก “ข้อมูลขนาดมหึมา” และส่วนใหญ่ก็ยังต้องมีการวัดความแม่นยำด้วยกรรมวิธีทางสถิติ ทั้งนี้ “ศาสตร์ของสถิติ” เดิมก็มีแรงบันดาลใจมาจากการวิเคราะห์ข้อมูล ซึ่งในสมัยแรกเริ่มนั้นยังไม่มีคอมพิวเตอร์ จึงมีรากฐานอยู่บนวิธีทางคณิตศาสตร์ซึ่งเป็นเครื่องมือที่มีประสิทธิภาพสูงสุดของมนุษย์ในตอนนั้น

เนื่องจากมีรากฐานอยู่บนคณิตศาสตร์ ซึ่งคนเราต้องคำนวณด้วยกระดาษและปากกา ทำให้การวิเคราะห์ทางสถิติแต่เดิมนั้นต้องพยายามย่อยข้อมูลให้อยู่ในรูปที่ง่าย และมีตัวแปรหลักๆ เพียงไม่กี่ตัว (จริงๆ แล้วคำกล่าวนี้ยังพอเป็นจริงกระทั่งในช่วงก่อนปี 2000 ที่คอมพิวเตอร์และอินเตอร์เน็ตยังไม่มีพลังมากนักเมื่อเทียบกับปัจจุบัน) เราอาจมองง่ายๆ ว่าสถิติศาสตร์คือการรับข้อมูลที่ย่อยมาแล้วมาวิเคราะห์อย่างง่ายๆ (ถึงแม้จะเป็นคณิตศาสตร์ระดับสูงก็ยังมีฐานจากจินตนาการของมนุษย์ซึ่งมีความซับซ้อนที่ไม่เพียงพอต่อข้อมูล Input ที่ซับซ้อน) และได้ผลลัพธ์เป็นข้อสรุปหรือคำทำนายทางสถิติซึ่งก็อยู่ในรูปของตัวเลขอย่างง่ายๆ เช่นกัน

พอมาในยุคที่ทั้งคอมพิวเตอร์มีความทรงพลังและข้อมูลในยุคอินเตอร์เน็ตไร้สายซึ่งมีมหาศาลมาก Deep Learning ซึ่งเป็นโมเดลทางคณิตศาสตร์ที่รองรับความซับซ้อนได้อย่างมหาศาลเนื่องจากมีตัวแปรหลายล้านตัวทำงานประสานกันอย่างลงตัวก็ได้แสดงความสามารถอย่างเต็มที่ จากแนวคิดเดิมๆ ที่ต้องย่อยข้อมูลให้ง่ายก่อน ก็เปลี่ยนเป็นรับข้อมูลดิบ (เช่น ภาพ เสียง วิดีโอ หรือกระทั่งตัวหนังสือหลายร้อยล้านคำในหนังสือหลายร้อยเล่ม) ที่แทนด้วยตัวเลขจำนวนมหาศาลได้โดยตรง นอกจากนี้ผลลัพธ์ของระบบยังสามารถออกเป็นตัวเลขจำนวนมากที่มีความซับซ้อนและสามารถแปลงกลับเป็นข้อมูลดิบ เช่น ภาพ เสียง วิดีโอ หรือกระทั่งบทความ (เทียบกับมนุษย์ที่สามารถเขียนบทความเพื่อสรุปเนื้อหาจากวิดีโอที่ดูได้) ความสามารถเช่นเดียวกับมนุษย์นี่เองที่ทำให้ Deep Learning กลายเป็นปรากฏการณ์ระดับโลก และความฝันที่เราจะมีสมองกลในนิยายวิทยาศาสตร์ทั้งหลายเช่น Jarvis จากเรื่อง Iron man เริ่มจะพอเห็นเค้าลางขึ้นมาได้

พลังของ Deep Learning ที่ข้ามขีดจำกัดของ Statistics หรือ Machine Learning ดั้งเดิมไปอย่างมาก

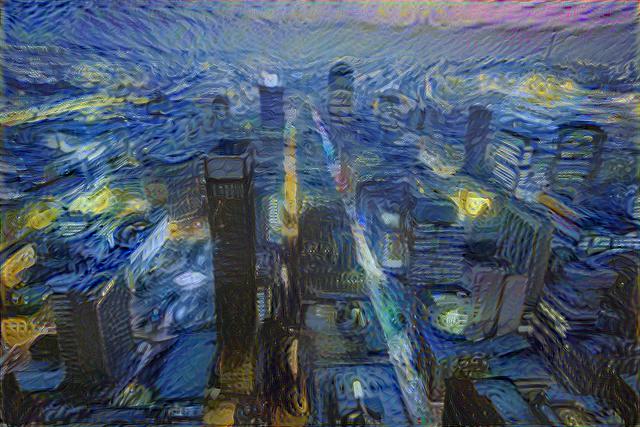

รูปถัดไปนี้แสดงตัวอย่าง Application ที่ปฏิวัติวงการศิลปะในปี 2015 จากทีมจาก Tubingen University งานนี้สามารถเปลี่ยนรูปถ่ายธรรมดาให้กลายเป็นผลงานของศิลปินระดับโลกเช่น Vincent Van Gogh ได้ ปัจจุบันงานนี้ถูกนำไปต่อยอดและดัดแปลงมากมาย เช่น เปลี่ยนรูป sketch ให้เป็นรูปถ่าย เปลี่ยนภาพกลางวันให้เป็นกลางคืน เปลี่ยนภาพถ่ายถนนท่ามกลางหิมะตกให้กลายเป็นภาพเดิม ณ วันอากาศสดใส เป็นต้น

ยังมีเรื่องที่น่าตื่นตะลึงอีกหลายเรื่องที่เมื่อก่อนปี 2012 ที่เราจะรู้จัก Deep Learning นักวิจัยทั้งหลายยังไม่กล้าแม้แต่จะคิด อาทิเช่น กำหนดหัวข้อประเด็นขึ้นมา 1 เรื่อง เช่นเดียวกับมนุษย์ เราสามารถให้ AI วาดรูปจากหัวข้อนั้นได้ หรือเขียน wikipedia ของหัวเรื่องนั้นได้ หรือกระทั่งแต่งนิยายจากหัวข้อนั้นก็ยังได้!